El vertiginoso desarrollo de la ciencia ha logrado avances impresionantes que necesitan ser divulgados entre la sociedad. Entre las nuevas fascinaciones de las mujeres y hombres de ciencia se encuentra la Bionanotecnología o también llamada Ingeniería Biomolecular, que destaca tanto por sus aportaciones a la ciencia e incidencia en el desarrollo tecnológico como por su carácter altamente interdisciplinario y polifacético donde convergen diferentes enfoques provenientes de la biología, química, física e ingeniería.

¿Qué es la bionanotecnología?

La bionanotecnología se origina de la fusión entre la nanotecnología y la biotecnología. Por un lado, la nanotecnología es la construcción y modelaje de la materia manipulando átomo por átomo aplicada en la ingeniería y manufactura a escala nanométrica. Por el otro, la biotecnología aprovecha diversas funcionalidades derivadas de procesos biológicos para aplicaciones específicas sin que importen los detalles moleculares y atómicos de las biomoléculas que llevan a cabo dichos procesos. Con base en ello, la bionanotecnología se define como la ingeniería y manufactura aplicada al diseño y modificación de los detalles atómicos de maquinarias y dispositivos moleculares basados en biomoléculas (ácido desoxirribonucleico -ADN-, proteínas, lípidos y carbohidratos) para que lleven a cabo funciones especificas a nivel nanométrico construidos mediante ensambladores biomoleculares. El rápido avance científico hace que el ámbito de influencia de la bionanotecnología aun se esté definiendo.

Para tener idea de las dimensiones de dichas máquinas es necesario decir que un nanómetro es la milmillonésima parte de un metro, o bien en nuestro mundo macroscópico equivaldría a comparar una moneda con el ¡diámetro de la tierra! La capacidad de visualización y manipulación de diminutos átomos y moléculas se logra con instrumentos y técnicas sofisticadas y refinadas de microscopía, cristalografía, espectroscopia y modelaje en computadora.

Las biomoléculas son las protagonistas

Las biomoléculas son los componentes de la célula desarrollados y optimizados a través de millones de años de evolución natural que mantienen la vida celular llevando a cabo todas las funciones necesarias para su crecimiento, sobrevivencia y reproducción.

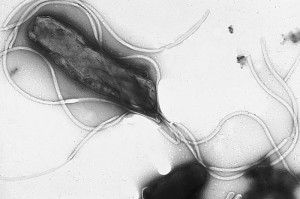

A pesar de que la célula es un sistema altamente complejo, base de la vida, se puede hacer una analogía (muy pobre, pero muy efectiva) con una máquina o un sistema compuesto de varias máquinas. Por ejemplo, el flagelo bacteriano y el complejo ATP sintasa funcionan esencialmente como motores generando movimiento mecánico alrededor de un eje y bombeando protones, mientras que la miosina realiza la contracción muscular; los anticuerpos y receptores de membrana detectan diversas moléculas por lo que son sensores; la actina y los microtúbulos son vigas y soportes, las enzimas son herramientas reparadoras y constructoras, los ribosomas son los ensambladores que construyen nuevas máquinas proteínicas en líneas de producción, el ADN es el control numérico, los lípidos forman vesículas contenedoras y la membrana lipídica que rodea la célula tal como si fuera una carcasa, etcétera. Todas estas entidades biológicas son delicadas moléculas de tamaño nanométrico con propiedades basadas principalmente en la química y debido a que en esencia realizan funciones de máquinas con precisión atómica también pueden ser caracterizadas y optimizadas con enfoques de la física y la ingeniería.

La célula crea las biomoléculas

Debido a que las biomoléculas son productos exclusivos del metabolismo celular, el desarrollo de la biología molecular en las últimas décadas ha sido de gran ayuda para la bionanotecnología permitiendo conocer los detalles de los mecanismos de muchas de estas “nanomáquinas”.

De inmensa importancia ha sido el desarrollo de la tecnología del ADN recombinante en la expansión de la bionanotecnología ya que ha permitido modificar y producir en gran escala de forma barata y rápida las “bionanomáquinas” y biomateriales necesarios para la bionanotecnología. Como el ADN posee toda la información necesaria para generar una proteína funcional (la gran mayoría de las “bionanomáquinas” están compuestas de proteína), es decir, contiene secuencias de ácidos nucleicos que codifican para los aminoácidos de una proteína, solo basta alterar y editar las secuencias del ADN para modificar una proteína particular con precisión atómica y así optimizar su funcionamiento y propiedades o generar nuevas y novedosas máquinas de proteína, las cuales son producidas en gran cantidad a partir de substratos baratos al crecer la célula con el gen en particular. La capacidad de manipular la célula es sin duda un cambio de paradigma que ha revolucionado tanto la ciencia como la forma en que vemos al mundo.

La Bionanotecnología trabaja interdisciplinariamente

Además de optimizar y modificar las biomoléculas a escala nanométrica para aplicaciones específicas, la bionanotecnología se ha adentrado en nuevos caminos y consolidado como un área altamente interdisciplinaria. Fusionándose con la ciencia de materiales ha desarrollado novedosos materiales híbridos entre compuestos inorgánicos y bioorgánicos, superando así la tradicional separación entre estos dos tipos de materia y borrando las fronteras entre la materia viva e inanimada.

Esta área usa proteínas y ácidos nucleicos como unidades programables de reconocimiento molecular, las cuales son acopladas (ligadas químicamente) a nanopartículas inorgánicas con propiedades ópticas, electrónicas y catalíticas diversas e interesantes, útiles para elaborar materiales y dispositivos inteligentes basados en compuestos híbridos que se auto-ensamblan en complejos supramoleculares nanométricos usados en aplicaciones bioanalíticas y biomédicas para diagnóstico, visualización y tratamiento de enfermedades y también para computación, electrónica, óptica y manufactura molecular.

Borrando Fronteras entre la Materia

El punto cardinal en la Bionanotecnología es la materia y la disolución de la frontera bioorgánica/inorgánica. Objetos vivos e inanimados están hechos por átomos. Las propiedades de la materia cambian de acuerdo con el patrón en que estén ordenados y enlazados los diferentes átomos que la componen: carbón y diamante, arena y chips de computadora, cáncer y tejido sano, tienen cierta disposición que hace la diferencia entre lo enfermo de lo sano y lo barato de lo valioso, tal como dice el apóstol de la nanotecnología, Erik Drexler en su famoso libro Máquinas de creación.

Hemos entrado en la era conjunta de la manipulación atómica y genética. Hay muchos riesgos pero también mucho potencial, que bien balanceado y en un ambiente democrático puede ser aprovechado para atender problemáticas específicas dentro del contexto mexicano.

Así, los bionanotecnólogos han creado nuevos horizontes en la ciencia, han descubierto excitantes áreas de desarrollo tecnológico y científico, novedosas e inéditas aplicaciones de las biomoléculas y han generado hitos de interdisciplinariedad al asociar disciplinas comúnmente separadas. La pregunta es, parafraseando al Nobel Richard Feynman en su discurso inaugural de la nanotecnología, ¿habrá suficiente espacio en el fondo de nuestra mente para apoyar la bionanotecnología en México?

Escrito por Armando Hernández y publicado originalmente en su blog acerca de bionanotecnología

[hozbreak]

Acerca del autor