Hace más de dos años, el 4 de julio de 2012, científicos de la Organización Europea para la Investigación Nuclear (CERN por sus siglas en inglés) mataron dos pájaros de un tiro: hicieron que Stephen Hawking perdiera una apuesta de cien dólares y pusieron fin a la búsqueda más intensiva de la que la ciencia moderna tiene registro. Esta búsqueda requirió de la construcción del Gran Colisionador de Hadrones (LHC), el complejo científico más grande del mundo con un costo superior a los nueve mil millones de dólares y un equipo de trabajo de más de diez mil científicos e ingenieros de todo el mundo. ¿Qué era lo que buscaban estos físicos con tanto empecinamiento? ¿Qué descubrimiento monumental requería de esfuerzos tan notables por parte de la comunidad científica internacional? Nada monumental, por el contrario, la búsqueda era en pos de algo en un orden de magnitud tan pequeño, que resulta incluso incomprensible. Lo que encontraron fue la última pieza de un rompecabezas llamado Modelo Estándar de las Partículas Elementales, una partícula que daría coherencia a los modelos físicos actuales. La infame, pero popularmente llamada Partícula de Dios: el bosón de Higgs.

Un gran descubrimiento… que no sorprendió a muchos

La primera imagen que viene a mi cabeza cuando recuerdo esa primera semana de julio de 2012 es la de un montón de periodistas tratando de explicar al mundo la importancia de un evento científico que sabían era de gran relevancia, pero que en realidad, no comprendían en lo más mínimo. Y es que la física de partículas subatómicas rara vez llega a los titulares, pero este descubrimiento ameritaba todos los reflectores.

Después de más de dos décadas de planeación, construcción y calibración de la instalación experimental más grande y compleja jamás construida, el Gran Colisionador de Hadrones cumplió el objetivo para el que había sido diseñado: la detección de una partícula cuyas características correspondían a las predicciones de lo que se esperaba era el bosón de Higgs.

El descubrimiento del bosón corrobora las predicciones teóricas que Peter Higgs, Gerald Guralnik, Richard Hagen, Tom Kibble, Robert Brout y Françoise Englert realizaron en la década de los sesentas –¡la cacería duró cerca de medio siglo!- con respecto a la física de partículas subatómicas. El hallazgo, que le brindó el premio Nobel a Higgs y a Englert, era el último eslabón para que el Modelo Estándar estuviera completo, validando el trabajo de décadas de muchos físicos teóricos. La comunidad científica esperaba con ansias la comprobación de la existencia del bosón, ¡no podía no existir! La alternativa, un escenario mucho más interesante para la ciencia según Stephen Hawking, hubiera implicado el replanteamiento de muchos de los postulados físicos vigentes. La existencia comprobada del bosón de Higgs abre la puerta a nuevas concepciones sobre la forma en la que se comporta nuestro universo y podría ser el parte aguas para superar el Modelo Estándar y dar paso a una “nueva física”.

Se estarán preguntando ¿por qué tanto alboroto?, ¿qué es lo que hace a esta partícula tan especial? o ¿por qué la física moderna dependía de su descubrimiento? Para responder todo esto tenemos que empezar por una pregunta más general… ¿qué demonios es un bosón?

La naturaleza cuántica de un bosón

A mediados del siglo pasado, los físicos elaboraron el Modelo Estándar, una ambiciosa colección de ecuaciones y postulados cuyo objetivo es describir el comportamiento de todas las partículas subatómicas y la forma en las que estas interactúan. Es una teoría de casi todo y, aunque no considera elementos como la fuerza de gravedad o la materia obscura, es el modelo más ambicioso de la física moderna.

De acuerdo al Modelo Estándar, todas las partículas pueden ser divididas en dos grupos: los fermiones y los bosones. Los fermiones son las partículas subatómicas que constituyen la materia y se dividen a su vez en quarks (que conforman a los protones y neutrones) y leptones (de los cuales el electrón es el más conocido). Los bosones, por otro lado, son las partículas responsables de las fuerzas fundamentales asociadas a la naturaleza. Los fotones, por ejemplo, son los bosones relacionados con el electromagnetismo; los gluones, se encuentran asociados a las interacciones fuertes de los núcleos atómicos, responsables de que protones y neutrones no se desintegren en un frenesí de quarks; y los bosones W y Z se relacionan a las interacciones débiles, responsables de cambiar las propiedades de los quarks y de otras curiosidades como el decaimiento radiactivo y la fusión nuclear que mantiene al Sol brillando y generando calor para que podamos aprovechar un buen día de playa. Hasta aquí todo “fácil”.

¿Qué papel juega Higgs en todo esto?

En el Modelo Estándar bosones y fermiones interactúan alegremente para darle forma al universo como lo conocemos, permitiendo la expansión de las galaxias, la formación de estrellas y la vida en nuestro planeta. Para que esta armonía sea posible, las interacciones entre materia y energía deben ajustarse a ciertas reglas o simetrías. Sin embargo, la evidencia empírica empezó a jugar en contra del modelo: había partículas con más masa de la esperada, fuerzas que actuaban de forma distinta a lo predicho… ¡El caos! ¡Sería necesario reevaluar todos los postulados de la física moderna! ¡Tardaríamos décadas en reconstruir un modelo igual de robusto! O…podríamos intentar balancear el Modelo Estándar tomando en cuenta las anomalías y ver qué pasa.

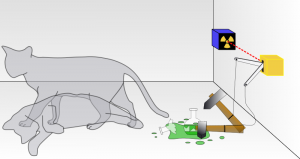

El postulado teórico que vino a balancear el Modelo Estándar es asombroso. En teoría, el universo estaría embebido en una especie de red –el Campo de Higgs- encargada de suministrar de masa a la materia del universo. ¡Todas las partículas del universo obtienen su masa por la interacción con este campo y el bosón de Higgs es una expresión de esta interacción! ¿Confundidos? Intentemos visualizar lo siguiente. Imagínense que el universo se reduce a la superficie de un –enorme- charco de lodo. Sobre la superficie del charco hay un sinnúmero de canicas, algunas se deslizan sobre la superficie tan rápido que no dejan rastro de su paso y ni siquiera se embarran de lodo, otras cruzan por el charco con menos gracia y no se libran de alguna salpicadura y están aquellas que van rodando sin mayor preocupación y están hechas una porquería. Las primeras canicas corresponden a las partículas que carecen de masa, como los fotones. Las segundas corresponden a fermiones como los electrones y a algunos bosones que tienen masas muy bajas. Las últimas canicas son los quarks, componentes de los protones y neutrones del núcleo de los átomos. En esta pequeña analogía, el campo de Higgs sería el lodo y el bosón de Higgs… ¡las ondas que se forman por la interacción entre las canicas y el lodo!

Explicar el campo y el bosón de Higgs resulta tan complicado que a finales del siglo pasado, el Ministerio de Ciencias del Reino Unido ofreció una botella de champaña de la mejor calidad a aquel que realizara la analogía más sencilla al respecto. El premio se lo llevo David Miller del University College of London. Aquí les dejo una interpretación animada de su solución, esperando que, entre ésta y el lodazal, queden claros los conceptos más generales del campo de Higgs.

http://www.youtube.com/watch?v=joTKd5j3mzk

A dos años de detectar el bosón

La historia del bosón de Higgs, desde su concepción hasta su descubrimiento, es uno de los mejores ejemplos de cómo debe funcionar la ciencia moderna. Por un lado, nos demostró el poder que tienen las teorías científicas para realizar descripciones y predicciones sobre nuestro universo. Pero también es un recordatorio de que la única forma de validar nuestras ideas, debe ser a través del método científico.

El túnel principal del Gran Colisionador de Hadrones no ha visto muchas colisiones recientemente y, contrario a lo esperado por actores sensacionalistas de opiniones pseudocientíficas, todavía no ha destruido al universo. El mantenimiento es costoso y llevará tiempo. Sin embargo, los datos que se generaron en el complejo durante su periodo operativo siguen siendo analizados y los resultados siguen sorprendiendo a muchos. Hoy se cuenta con evidencia (observen la primera imagen de este artículo) de el decaimiento del bosón de Higgs hacia fermiones (su descubrimiento se basó exclusivamente en el decaimiento a bosones de baja masa) y se tienen más elementos para analizar a fondo la naturaleza del campo de Higgs. Recientemente se presentó el plan de trabajo para los próximos años de los distintos experimentos activos en el LHC.

El Modelo Estándar está completo. Ahora, la labor de la ciencia es terminar de entenderlo y expandirlo con la ayuda de las nuevas evidencias. Seguimos muy lejos de tener una “teoría de todo”, pero no cabe duda que dimos un paso gigante en esa dirección.

El físico teórico Kip Thorne escribía en El futuro del espacio tiempo, obra de 2002: «En algún momento entre 2008 y 2030 se descubrirán ondas gravitacionales procedentes de la singularidad del Big-Bang [y] seguirá una era, que durará hasta 2050, en la que se harán grandes esfuerzos para medir el espectro de las ondas gravitacionales primordiales». Si los datos que hace poco presentaron en una conferencia de prensa John Kovac y sus colegas del Centro de Astrofísica Harvard-Smithsonian superan el escrutinio, la era predicha por Kip Thorne comienza en este momento.

El físico teórico Kip Thorne escribía en El futuro del espacio tiempo, obra de 2002: «En algún momento entre 2008 y 2030 se descubrirán ondas gravitacionales procedentes de la singularidad del Big-Bang [y] seguirá una era, que durará hasta 2050, en la que se harán grandes esfuerzos para medir el espectro de las ondas gravitacionales primordiales». Si los datos que hace poco presentaron en una conferencia de prensa John Kovac y sus colegas del Centro de Astrofísica Harvard-Smithsonian superan el escrutinio, la era predicha por Kip Thorne comienza en este momento.